The Conversation : "Pourquoi l’intelligence artificielle risque de continuer à tuer"

Suite à ces performances impressionnantes dans ce domaine prometteur et passionnant qu’est l’intelligence artificielle (IA), des investissements massifs ont été réalisés par les universités mais aussi par les plus grands groupes internationaux pour développer ce nouveau potentiel. Néanmoins, malgré l’efficacité impressionnante des DNN dans de nombreux domaines d’applications (reconnaissance visuelle ou vocale, traduction, imagerie médicale, etc.) des questions se posent sur les limites du deep learning dans d’autres domaines tels que le pilotage de véhicules autonomes par exemple.

Pour comprendre les limites de l’IA actuelle, il faut comprendre d’où viennent les DNN et surtout de quelles zones du cerveau humain ils en constituent l’analogue formel, ce qui est souvent très mal connu dans l’ingénierie industrielle mais aussi dans certains centres de recherche. Depuis cette nouvelle révolution, ils utilisent le Deep learning comme une « baguette magique » sans en connaître ni l’origine, ni les limites. Sur ce point, le titre du rapport Villani – « Donner un sens à l’intelligence artificielle » – est révélateur de ce malaise profond.

Explication des DDN.

D’où vient le deep learning ?

L’origine des réseaux de neurones artificiels remonte aux années 1940 et aux découvertes fondatrices en neurosciences et en psychologie de McCulloch et Pitts (premier modèle mathématique d’un neurone) et de Donald Hebb (formalisation des règles d’apprentissage synaptique). L’objectif de ces chercheurs était de comprendre comment les neurones, briques élémentaires du cerveau, pouvaient générer la psyché.

Ce travail séminal a conduit à la conception en 1958 du premier réseau de neurones artificiels par le psychologue américain Frank Rosenblatt : le Perceptron. Ces premières recherches ont évidemment été suivies d’évolutions importantes, par exemple sur la base des travaux en neurosciences de Hodgkin et Huxley qui spécifient la dynamique temporelle de l’intégration neuronale ou les travaux en informatique et en mathématiques de Bernard Widrow et Ted Hoff qui proposèrent l’utilisation d’algorithmes de descente de gradient plus efficaces pour la modification des connexions synaptiques des réseaux de neurones.

Ces optimisations mathématiques ont ensuite été approfondies dans les années 1980 par les recherches en sciences cognitives de David Rumelhart, Geoffrey Hinton, et James McClelland, parmi les membres du Parallel Distributed Processing Research Group qui ont permis l’optimisation de la modification des connexions synaptiques dans des couches profondes de neurones et l’avènement du perceptron multi-couches (ou multi-layer perceptron, MLP). Les DNN, développés par des auteurs tels que Geoffrey Hinton, Yann LeCun ou Yoshua Bengio, sont les descendants directs du MLP.

Existe-t-il un lien entre Deep Learning et cerveau ?

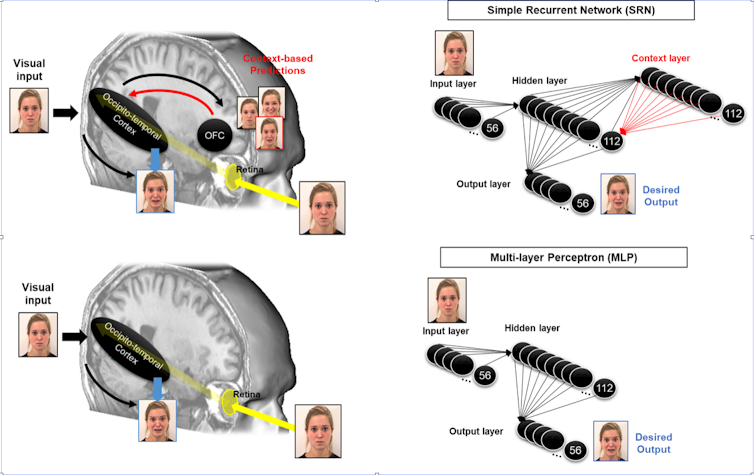

Malgré l’origine interdisciplinaire et inspirée du fonctionnement du cerveau des DNN, on peut se demander dans quelle mesure ces algorithmes simulent encore quelque chose du cerveau humain. Les DNN ont été conçus pour réaliser des tâches de reconnaissance et classification d’images par exemple. À cette fin, les DNN utilisent différentes couches de convolution et de pooling avant la reconnaissance de l’image.

Concernant les couches de convolutions, les travaux de Hubel et Wiesel dans les années 1960 ou de Jones et Palmer dans les années 1980 montrent la possibilité de simuler par cette méthode la probabilité de réponse de neurones du cortex visuel primaire. De nombreuses recherches en sciences cognitives, dont nos propres travaux, utilisent ainsi ce processus pour simuler la réponse de ces neurones de façon neuro-inspirée.

Concernant le processus de pooling, différents travaux réalisés depuis 30 ans en neurosciences et en psychologie cognitive montrent comment le cerveau réalise ce processus d’abstraction au niveau de la voie occipito-temporale. Ainsi, les travaux de Rufin Vogels ou de Keiji Tanaka montrent comment cette voie permet l’identification ou la classification visuelle indépendamment des propriétés de surface de l’image comme la forme, la couleur, la distance ou la position des objets dans l’image. Ces aires cérébrales sont donc sensibles aux mêmes informations que les couches perceptives apprises par un DNN lors du processus de pooling.

Plus surprenant encore, les recherches de Rodrigo Quian Quiroga et de ses collaborateurs ont montré l’existence de neurones spécifiques à des concepts ou à des identités (par exemple des neurones « Jennifer Aniston », ou « Tour de Pise »). Ils s’activent lors d’un accès direct au concept tel que le nom écrit « Jennifer Aniston ». Encore plus passionnant au regard de l’avenir de l’IA, les travaux de Quiroga montrent que cette activité neuronale est corrélée avec la perception consciente d’un stimulus de l’environnement.

En résumé, bien que simplifiés et mathématiquement optimisés par rapport à un cerveau biologique, les DNN reproduisent les processus de convolution/abstraction de cette zone très spécifique du cortex. Des travaux de neurosciences cognitives récents montrent ainsi, par implants d’électrodes cérébrales ou par IRM fonctionnel, la similitude de fonctionnement entre DNN et cette voie occipito-temporale.

Une IA plus fiable parce qu’inspirée du cerveau ?

Les recherches fondamentales interdisciplinaires sur les DNN ont permis d’aboutir à des applications impressionnantes dans de nombreux domaines : reconnaissance et classification visuelle, reconnaissance vocale, traduction, jeux de go, composition musicale, etc. Malheureusement, par méconnaissance des travaux en sciences cognitives qui en sont à l’origine, les DNN restent actuellement trop souvent utilisés comme une « baguette magique » permettant de résoudre tous et n’importe quels problèmes.

Dans l’exemple des voitures autonomes, l’utilisation aveugle de DNN couplés directement à des systèmes de contrôle des actions du véhicule serait très risquée : ce serait équivalent à demander à un chauffeur de taxi qui a perdu plus de 80 % de son cerveau suite à un accident (et ne conservant que cette voie occipito-temporale) de conduire une voiture. Il n’est tout simplement pas possible de demander à ces systèmes plus que ce pour quoi ils ont été conçus à l’origine au risque de produire des accidents dramatiques.

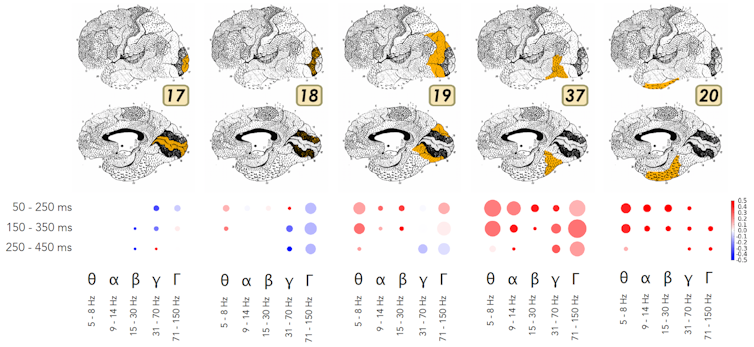

Les aires cérébrales humaines impliquées dans l’anticipation (figure ci-dessous), l’orientation spatiale ou les fonctions sensori-motrices impliquées dans la conduite dans un environnement complexe sont très différentes des processus neuronaux à l’œuvre au niveau de la voie occipito-temporale. Ces processus neuronaux impliqués dans la compréhension et la planification de l’action sont réalisés par le cortex occipito-pariétal sur la base de processus neuronaux très différents de la voie occipito-temporale ! Ce sont des neurones très différents et sensibles par exemple à la distance, la position ou la vitesse. Autant de paramètres qui déterminent la manière dont nous pouvons agir sur l’environnement.

L’utilisation aveugle de DNN (ou d’autres systèmes artificiels) sans retour, ni comparaison à la neuro-inspiration pour des fonctions cognitives différentes n’est pas seulement limité en performance, c’est tout simplement dangereux. Nous ne prétendons pas que la neuro-inspiration est la seule voie efficace pour une IA plus sûre. Néanmoins, au regard du passé tumultueux de l’IA, et en particulier au regard de l’efficacité maintenant démontrée de systèmes neuro-inspirés comme les DNN comparativement aux méthodes d’ingénierie antérieures utilisées (pour la reconnaissance visuelle par exemple), il nous semble primordial de comprendre comment le cerveau réalise d’autres fonctions cognitives (contrôle moteur, intégration multi-sensorielle, etc.) afin de les comparer aux techniques d’ingénierie actuelles réalisant ces fonctions dans l’optique de produire des IA plus sûres et plus efficaces.

Si la recherche en IA se faisait en plus étroite collaboration avec les sciences cognitives, cela permettrait :

-

de comprendre et de simuler les zones du cerveau qui ne sont pas encore appréhendées par le Deep Learning.

-

de proposer des IA plus fiables et plus performantes en comparaison avec les performances humaines.

Ce défi passe par un travail interdisciplinaire qui nécessite bien sûr des mathématiques et de l’informatique mais aussi des neurosciences, de la psychologie cognitive, sans oublier des recherches en électronique et en physique pour développer les nouveaux processeurs neuronaux en cours de déploiement. Il s’agit de dépasser enfin les limites des machines de Turing-Von Neumann qui a dominé l’industrie électronique et l’informatique depuis la seconde guerre mondiale.![]()

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

Mis à jour le30 novembre 2018

Vous aimerez peut-être aussi

- The Conversation Junior : "Alec et Eloa : « Pourquoi est-ce que quand on monte en haut d’une montagne il fait plus froid alors qu’on se rapproche du Soleil ? »"

- The Conversation : "Images de science : Le métal qui se prenait pour du verre"

- The Conversation : "Tuer pour la science ? Une nouvelle expérience de Milgram"

- The Conversation : "Le rêve de Jeff Bezos ou peut-on, vraiment, rajeunir en reprogrammant nos cellules ?"

L'auteur

Martial Mermillod

Chercheur au Laboratoire de psychologie et neurocognition

Université Grenoble Alpes